Esta es la segunda parte del artículo que busca resumir el extenso y detallado reporte Artificial Intelligence Index Report elaborado por el Human Centered Artificial Intelligence Institute de la Universidad de Standfor.

Una vez más, en este resumen destacamos aquellos aspectos y temas del reporte más relevantes para la gestión de las organizaciones y los negocios.

Contenido

IA responsable

Incidentes y riesgos

Privacidad y gobierno de datos

Transparencia y capacidad de explicación

10 principales conclusiones

Nota - en este artículo usamos el término inteligencia artificial (IA) para referirnos a la IA en cualquier de sus modalidades, excepto en donde explícitamente se indique lo contrario.

IA responsable

La IA se va integrando cada vez más en casi todas las facetas de nuestras vidas. Esta integración se está produciendo en sectores como la educación, las finanzas y la salud, donde las decisiones críticas provienen de complejos algoritmos. Esta tendencia promete aportar muchas ventajas; sin embargo, también introduce riesgos potenciales. Por ello, se está prestando especial atención al desarrollo y despliegue responsable de los sistemas de IA.

Incidentes y riesgos

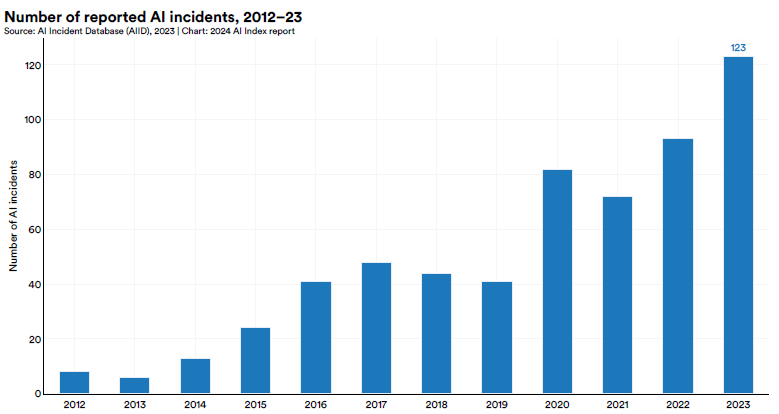

La Base de Datos de Incidentes de IA (AIID, por sus siglas en inglés) realiza un seguimiento de los casos de mal uso ético de la IA, como los coches autónomos que causan la muerte de peatones o los sistemas de reconocimiento facial que conducen a detenciones erróneas. El número de incidentes de IA sigue aumentando cada año. En 2023, se notificaron 123 incidentes, un 32,3 % más que en 2022.

Desde 2013, los incidentes de IA se han multiplicado por más de veinte. El aumento continuo de los incidentes notificados probablemente se deba tanto a una mayor integración de la IA en las aplicaciones del mundo real como a una mayor concienciación sobre su potencial para el mal uso ético. Sin embargo, es importante señalar que, a medida que aumenta la concienciación, también mejoran el seguimiento y la notificación de incidentes, lo que indica que es posible que no se hayan notificado todos los incidentes anteriores.

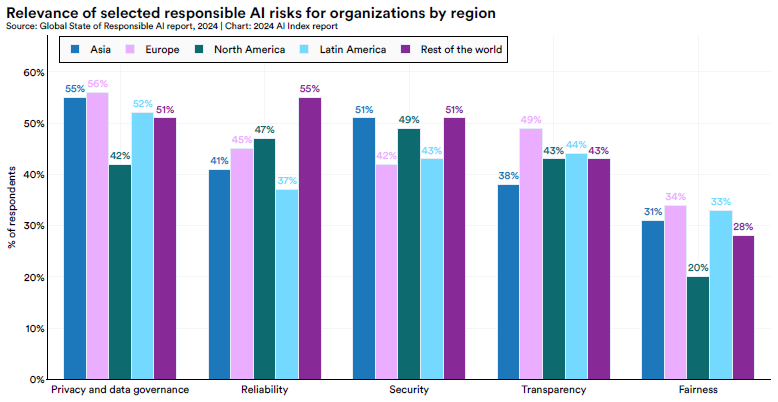

El reporte recogió las respuestas de más de mil organizaciones a lo largo de 20 países en 19 industrias para identificar los mayores riesgos de la IA relacionados con su actividad. Se evaluó cinco grandes aspectos:

Imparcialidad y sesgo - recopilación de datos representativos, evaluación de rendimiento en diferentes grupos demográficos, uso de técnicas de mitigación de sesgos, etc.

Privacidad y gobierno de datos - datos cumplen con las leyes y se utilizan con consentimiento, cumplen con integridad, unicidad, coherencia y

exactitud, etc.

Transparencia y capacidad de explicación - documentación de los procesos, uso de herramientas para explicar las decisiones del modelo de IA, etc.

Confiabilidad - mitigación de errores y tratamiento de resultados de baja confianza, modelos de medida de confianza de los resultados, etc.

Seguridad - medidas básicas de ciberseguridad, personal dedicado a la ciberseguridad de la IA formado explícitamente para ello, etc.

Las organizaciones en Latinoamérica priorizan estos riesgos de la siguiente manera:

Privacidad y gobierno de datos (52%)

Transparencia y capacidad de explicación (44%)

Seguridad (43%)

Confiabilidad ((37%)

Imparcialidad y sesgo (33%)

Privacidad y gobierno de datos

Obtener un consentimiento genuino e informado para la recopilación de datos de entrenamiento es especialmente difícil en el caso de los LLM (Large Language Model), que se basan en cantidades masivas de datos. En muchos casos, los usuarios desconocen cómo se utilizan sus datos o el alcance de su recopilación. Por lo tanto, es importante garantizar la transparencia en torno a las prácticas de recopilación de datos.

En relación con esto, puede haber compensaciones entre la utilidad derivada de los sistemas de IA y la privacidad de las personas. Lograr el equilibrio adecuado es complejo. Así mismo, la anonimización adecuada de los datos para mejorar la privacidad al tiempo que se conserva su utilidad para el entrenamiento de la IA puede ser un reto técnico, ya que siempre existe el riesgo de que los datos anonimizados puedan ser reidentificados.

El reporte evaluó seis medidas para mitigar este riesgo en la industria:

Comprobaciones para garantizar que los datos cumplen todas las leyes y reglamentos pertinentes y se utilizan con consentimiento.

La recopilación y preparación de datos incluye su evaluación de la integridad, unicidad, coherencia y exactitud.

Comprobaciones para garantizar que los datos son representativos con respecto al entorno demográfico en el que se utiliza el modelo/sistema final.

Auditorías y actualizaciones periódicas de los datos para garantizar su pertinencia.

Proceso de documentación y trazabilidad de los conjuntos de datos a lo largo del ciclo de vida de la IA.

Planes de corrección y documentación de los conjuntos de datos con deficiencias.

En el mundo las organizaciones en promedio han implementado 2.2 de las seis medidas, mientras que en Latinoamérica se han implementado 2.5. Por otro lado, en el mundo en promedio 10% de las organizaciones no han implementado una sola medida aún, mientras que en Latinoamérica ese porcentaje sube a 19%.

Transparencia y capacidad de explicación

La transparencia y la capacidad de explicación plantean varios retos. En primer lugar, la complejidad inherente de los modelos avanzados, en particular los basados en el aprendizaje profundo, crea un escenario de «caja negra» en el que es difícil, incluso para los desarrolladores, entender cómo estos modelos procesan las entradas (datos) y producen las salidas (resultados). Esta complejidad obstaculiza la comprensión y complica la tarea de explicar estos sistemas a los no expertos.

En segundo lugar, existe un posible balance entre la complejidad de un modelo y su capacidad de explicación. Los modelos más complejos pueden ofrecer un rendimiento superior, pero tienden a ser menos interpretables que los modelos más sencillos, como los árboles de decisión. Esta situación crea un dilema: elegir entre modelos de alto rendimiento pero opacos (poco explicables) y alternativas más transparentes, aunque menos precisas.

El reporte evaluó cuatro medidas para mitigar este riesgo en la industria:

Documentación del proceso de desarrollo, detallando las opciones de diseño del algoritmo, las fuentes de datos, los casos de uso previstos y las limitaciones.

Programas de formación para las partes interesadas (incluidos los usuarios) sobre los casos de uso previstos y las limitaciones del modelo.

Priorización de modelos más sencillos en los que es crucial una alta interpretabilidad, aunque se sacrifique algo de rendimiento.

Utilizar herramientas de capacidad de explicación del modelo para dilucidar las decisiones del modelo.

En el mundo las organizaciones en promedio han implementado 1.4 de las cuatro medidas, mientras que en Latinoamérica se han implementado 1.5. Por otro lado, en el mundo en promedio 12% de las organizaciones no han implementado una sola medida aún, mientras que en Latinoamérica ese porcentaje sube a 20%.

10 principales conclusiones

1 La IA supera a los humanos en algunas tareas, pero no en todas

La IA ha superado el rendimiento humano en varias pruebas de referencia, como la clasificación de imágenes, el razonamiento visual y la comprensión del inglés. Sin embargo, se queda atrás en tareas más complejas, como las matemáticas de competición, el razonamiento visual de sentido común y la planificación.

2 La industria sigue dominando la investigación de vanguardia en IA

En 2023, la industria produjo 51 modelos notables de aprendizaje automático, mientras que el mundo académico sólo contribuyó con 15. En 2023 también se produjeron 21 modelos notables como resultado de colaboraciones entre la industria y el mundo académico, un nuevo récord.

3 Los modelos más avanzados son mucho más caros

Según las estimaciones del reporte, los costes de formación de los modelos de IA más avanzados han alcanzado niveles sin precedentes. Por ejemplo, se calcula que el GPT-4 de OpenAI utilizó un estimado de 78 millones de dólares en computación, mientras que el Gemini Ultra de Google costó 191 millones de dólares.

4 Estados Unidos aventaja a China, la UE y el Reino Unido como principal fuente de los mejores modelos de IA

En 2023, 61 modelos de IA destacados procederán de instituciones con sede en Estados Unidos, muy por delante de los 21 de la Unión Europea y los 15 de China.

5 Hay una grave carencia de evaluaciones sólidas y estandarizadas de la responsabilidad de la AI.

Una nueva investigación del Índice AI revela una importante falta de estandarización en los informes sobre IA responsable. Los principales desarrolladores, incluidos OpenAI, Google y Anthropic, prueban principalmente sus modelos con diferentes puntos de referencia de IA responsable. Esta práctica complica los esfuerzos para comparar sistemáticamente los riesgos y las limitaciones de los mejores modelos de IA.

6 La inversión en IA generativa se dispara

A pesar de la disminución de la inversión privada en IA en general en 2023, la financiación para la IA generativa se disparó, casi multiplicándose por ocho desde 2022 hasta alcanzar los 25.200 millones de dólares. Los principales actores en el espacio de la IA generativa, incluidos OpenAI, Anthropic, Hugging Face e Inflection, informaron rondas sustanciales de recaudación de fondos.

7 La IA aumenta la productividad de los trabajadores y mejora la calidad del trabajo

En 2023, varios estudios evaluaron el impacto de la IA en el trabajo, sugiriendo que la IA permite a los trabajadores completar tareas más rápidamente y mejorar la calidad de su producción. Estos estudios también demostraron el potencial de la IA para reducir las diferencias de calificación entre los trabajadores poco calificados y los muy calificados. Sin embargo, otros estudios advierten de que utilizar la IA sin la supervisión adecuada puede reducir el rendimiento.

8 El progreso científico se acelera aún más gracias a la IA

En 2022, la IA empezó a hacer avanzar los descubrimientos científicos. En 2023, sin embargo, se lanzaron aplicaciones de IA relacionadas con la ciencia aún más significativas: desde AlphaDev, que hace más eficiente la clasificación algorítmica, hasta GNoME, que facilita el proceso de descubrimiento de materiales.

9 Aumenta drásticamente el número de normativas sobre IA en Estados Unidos

El número de normativas relacionadas con la IA en Estados Unidos ha aumentado significativamente en el último año y en los últimos cinco años. En 2023, había 25 reglamentos relacionados con la IA, frente a solo uno en 2016. Solo el año pasado, el número total de normativas relacionadas con la IA creció un 56,3%.

10 Los ciudadanos de todo el mundo son más conscientes del impacto potencial de la IA y están más nerviosos

Una encuesta de Ipsos muestra que, en el último año, la proporción de quienes piensan que la IA afectará drásticamente a sus vidas en los próximos tres a cinco años ha aumentado del 60% al 66%. Además, el 52% expresa nerviosismo ante los productos y servicios de IA, lo que supone un aumento de 13 puntos porcentuales desde 2022. En Estados Unidos, los datos de Pew sugieren que el 52 % de los estadounidenses afirman sentirse más preocupados que entusiasmados con la IA, lo que supone un aumento con respecto al 37 % de 2022.

¡Gracias por llegar hasta aquí! Si te ha gustado este artículo no olvides de compartirlo.

Y si deseas profundizar sobre este tema y evaluar cómo desde Moddula podemos ayudarte, puedes hacerlo programando una sesión exploratoria en este enlace:

¡Hasta la próxima semana!