Según la distinguida revista The Economist la inteligencia artificial (IA) está cambiando los negocios, la política y la ciencia. Y de la mano de estos cambios aparecen diversas preguntas como ¿destruirá esta tecnología los puestos de trabajo o los hará más satisfactorios? ¿podrá descubrir nuevos aspectos del mundo que han escapado a la mente humana para mejorar la vida de las personas? ¿las elecciones se verán inundadas de desinformación o podrá utilizarse la IA para eliminar las falsedades?

Desde el año 2017 el Human Centered Artificial Intelligence de la Universidad de Standfor presenta el Artificial Intelligence Index Report desde donde busca proporcionar datos imparciales, rigurosamente examinados y de amplia procedencia para que los responsables políticos, investigadores, ejecutivos, periodistas y el público en general adquieran un conocimiento más profundo y matizado del complejo campo de la IA.

Este artículo, que consta de dos partes, busca resumir el extenso reporte de este año de más de 500 páginas, identificando y resaltando aquellos temas y estadísticas que tienen mayor relevancia e impacto en la gestión de las organizaciones y los negocios.

Contenido

Rendimiento técnico

Rendimiento general

Lenguaje

Imagen

Video

Razonamiento

Audio

Agentes inteligentes

Robótica

Impacto medioambiental

Nota - en este artículo usamos el término inteligencia artificial (IA) para referirnos a la IA en cualquier de sus modalidades, excepto en donde explícitamente se indique lo contrario.

Rendimiento técnico

El reporte ofrece una visión global de los avances de la IA en 2023 en trece diferentes aspectos. A continuación revisamos nueve de ellos.

Rendimiento general

La IA ha ido progresivamente superando la capacidad humana en diferentes tareas: 2015 clasificación de imágenes, 2017 comprensión básica de lectura, 2020 razonamiento visual y 2021 inferencia en lenguaje natural. Hasta el término de 2023 aún hay algunas tareas en donde la IA aún no logra superar al ser humano como razonamiento visual de sentido común y nivel avanzado de solución de problemas matemáticos.

Lenguaje

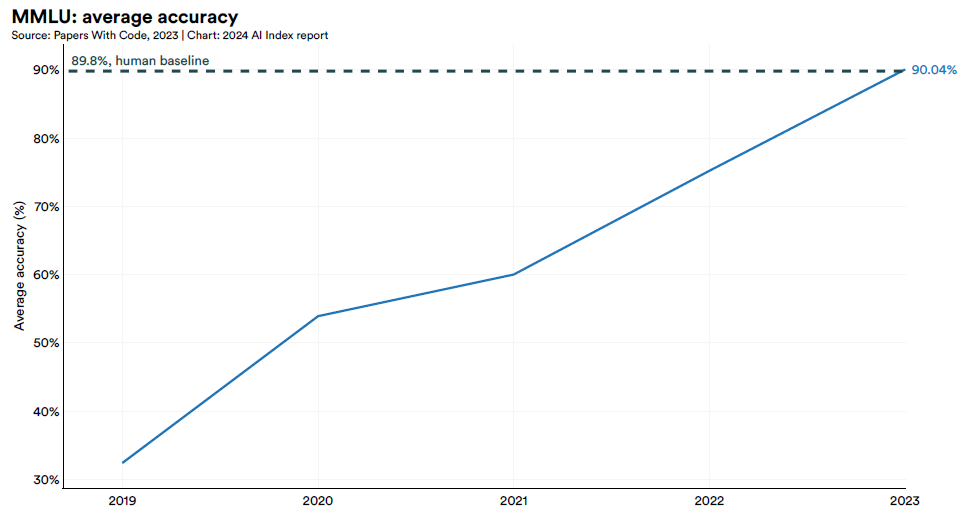

En los últimos años se han creado diferentes tipos de pruebas (SQuAD - respuestas a preguntas, SuperGLUE - comprensión de lenguaje) para medir el desempeño de la IA en la comprensión del lenguaje en comparación con la del ser humano. Uno de las pruebas más completas llamado MMLU (comprensión del lenguaje multitarea) muestra como en solo cinco años la IA, a través de sus diferentes modelos, ha sido capaz de pasar de un rendimiento de 30% (2019) a más del 90% (2024), superando el redimiento humano de 89.8%.

A pesar de sus notables logros, la IA generativa siguen siendo susceptibles a las inexactitudes fácticas y a la alucinación (creación de información aparentemente realista, pero falsa). Sin embargo, en solo 3 años se nota una mejora significativa: GPT-4 de 2024 produce respuestas tres veces más veraces que GPT-2 de 2021 (medido a través de la prueba TruthfulQA). Por otro lado, a través de la prueba HaluEval lanzada en el 2023, se ha identificado que ChatGPT produce información no verificable (alucinación) en el 19.5% de sus respuesta, es decir, ¡1 de cada 5 respuestas!

Imagen

Los generadores de imágenes actuales son tan avanzados que la mayoría de la gente tiene dificultades para distinguir entre las imágenes generadas por la IA y las imágenes reales de rostros humanos. En solo dos años Midjourney pasó de hacer una imagen tipo dibujo animado a crear representaciones sorprendentemente realistas.

La IA ha avanzado considerablemente en otras áreas relacionadas al procesamiento de imágenes:

Seguimiento de instrucciones - que consiste en interpretar instrucciones de texto relacionadas con imágenes. Por ejemplo, el modelo de IA podría recibir una imagen que incluye varios ingredientes y un pedido a que responda cómo combinar dichos ingredientes para preparar una comida saludable. En enero de 2024 el modelo de IA GPT-4V superó al ser humano en esta capacidad de seguir instrucciones a partir de imágenes, según la prueba VisiT-Bench. El avance de esta capacidad en la IA es fundamental para el desarrollo de asistentes avanzados de IA.

Edición - que consiste en modificar imágenes basado en órdenes (prompt) de texto. Esta capacidad tiene múltiples aplicaciones especialmente en la ingeniería, el diseño industrial y la industria de las películas. Aquí se pueden realizar muchas tareas como reemplazar objetos, cambiar el fondo, mover objetos, cambiar el color, agregar objetos, alterar ciertas partes, etc.

Sin embargo, dos nuevos desarrollos están permitiendo hacer cosas que hasta hace poco eran imposibles:

ControlNet - a través de un control condicional guia la salida creada por un generador de imágenes especificando condiciones que debe cumplir la imagen generada. En el ejemplo se hace un trazo con líneas y luego se le pide que genere una imagen humana, un cocinero y una estatua de Lincoln. El modelo de IA ControlNet es capaz de generar dichas imágenes siguiendo los trazos iniciales.

Instruct-NeRF2NeRF - puede editar imágenes 3D usando solamente instrucciones de texto. En el ejemplo, usando una sola imagen 3D (lado izquierdo) se pueden genenar muchas imágenes nuevas (lado derecho) ingresando las respectivas instrucciones de texto.

Segmentación - que consiste en asignar píxeles individuales (máscaras) de la imagen a categorías específicas (por ejemplo: humano, bicicleta o calle). El modelo Segment Anything de Meta lanzado en 2023 ha logrado identificar más de 1 billón de máscaras a través del procesamiento de 11 millones de imágenes. Esta base de datos va a ayudar a acelerar el entrenamiento de futuros modelos segmentadores.

Reconstrucción 3D - que consiste en construir imágenes 3D a partir de imágenes 2D. Esta funcionalidad se usa en el sector de la medicina, robótica y realidad virtual. En 2023 se logró construir la base de imágenes Skoltech3D con 1,4 millones de imágenes de 107 escenas capturadas desde 100 puntos de vista bajo 14 condiciones de iluminación distintas. Este conjunto de datos representa una importante mejora con respecto a los existentes para mejorar considerablemente esta funcionalidad.

Video

La IA puede generar videos a partir de una instrucción de texto o de una imagen. Sin embargo, en la mayoría de las aplicaciones solo pueden crear videos cortos y de limitada resolución, debido a la alta complejidad en producirlos y la menor cantidad de datos para el entrenamiento. Emu Video, un nuevo generador de video creado por Meta, ha logrado un avance significativo creando primero una imagen a partir de texto, y luego el video a partir del texto y la imagen.

Razonamiento

Razonamiento general - El razonamiento general se refiere a la capacidad de los sistemas de IA para razonar en ámbitos más amplios que específicos. Como parte de un reto de razonamiento general, por ejemplo, se puede pedir a la IA que razone sobre múltiples temas en lugar de realizar una tarea específica (por ejemplo, jugar al ajedrez).

Para medir la capacidad de razonamiento de la IA se creó la prueba MMMU (Massive Multi-discipline Understanding) que contiene 11,500 preguntas de nivel universitario en seis diferentes disciplinas. En esta prueba el rendimiento promedio del ser humano es de 82.60% mientras que el modelo de IA con mejor rendimiento (Gemini Ultra) ha obtenido 59.40%.

Razonamiento matemático - Las pruebas comparativas de resolución de problemas matemáticos evalúan la capacidad de razonamiento matemático de los sistemas de IA. Los modelos de IA pueden probarse con una serie de problemas matemáticos, desde los de primaria hasta los de competición. La IA ha logrado avances significativos en solo dos años. En 2021 la IA solo pudo resolver el 6.9% de los problemas de la prueba MATH. Sin embargo, en 2023 GPT-4 resolvió exitosamente el 84.3%. En rendimiento promedio del ser humano en esta prueba es de 90%.

Razonamiento visual - Se refiere a la capacidad del modelo IA para “razonar” a partir de los datos visuales y textuales. El crecimiento de la capacidad de respuesta de la IA en este segmento también ha sido considerable llegando a obtener un score de 81.6 versus el promedio de 85.0 del ser humano en la prueba VCR (Visual Commonsense Reasoning) que mide la capacidad para responder la respuesta correcta y escoger el apropiado fundamento detrás de esa respuesta.

Audio

2023 marcó un año importante en el campo de la generación de audio, que consiste en crear contenidos de audio sintético, desde el habla humana hasta archivos musicales. Este avance se puso de manifiesto con el lanzamiento de varios generadores de audio destacados, como UniAudio, MusicGen y MusicLM.

La IA es ahora capaz de crear un discurso de voz de alta calidad, sonidos y música, solamente a partir de una instrucción de texto. Para ello los modelos de IA han sido entrenados con miles de horas de audio (165 mil horas para el caso de UniAudio).

Agentes inteligentes

Los agentes inteligentes de IA, sistemas autónomos o semiautónomos diseñados para actuar en entornos específicos y alcanzar objetivos, representan una apasionante frontera en la investigación sobre IA. Estos agentes tienen una amplia gama de aplicaciones potenciales, desde la asistencia en la investigación académica y la programación de reuniones hasta la facilitación de las compras en línea y la reserva de vacaciones.

Para medir el rendimiento de los agentes inteligentes se creó la prueba AgentBench que evalúa al modelo de agente IA en ocho diferentes dimensiones incluyendo navegación en internet, compras en línea, gestión del hogar, rompecabezas, juegos digitales, etc. Se puede ver que en solo un año los nuevos modelos de agente de IA han duplicado su rendimiento.

Robótica

Con el tiempo, la IA se ha ido integrando cada vez más en la robótica, mejorando la capacidad de los robots para realizar tareas complejas. Especialmente con el auge de los modelos fundacionales, esta integración permite a los robots aprender iterativamente de su entorno, adaptarse con flexibilidad a nuevos escenarios y tomar decisiones autónomas.

PaLM-E es un nuevo modelo de IA de Google que fusiona la robótica con el modelado del lenguaje para abordar tareas del mundo real como la manipulación robótica y tareas de conocimiento como la respuesta a preguntas y el subtitulado de imágenes.

Impacto medioambiental

En esta sección el reporte examina las tendencias en el impacto medioambiental de los sistemas de IA, destacando la evolución del panorama de la transparencia y la concientización.

Históricamente, los desarrolladores de modelos de IA rara vez revelaban la huella de carbono de sus sistemas, dejando que los investigadores hicieran sus mejores estimaciones. Recientemente, se ha producido un cambio hacia una mayor apertura, especialmente en lo que respecta a los costes de carbono del entrenamiento de los modelos de IA. Sin embargo, la divulgación de los costes medioambientales asociados a la inferencia -un problema potencialmente más importante- sigue siendo insuficiente.

Entrenamiento - Uno de los principales problemas a la hora de evaluar el impacto medioambiental de los modelos de IA es la falta de transparencia sobre las emisiones, especialmente de los principales desarrolladores como OpenAI, Google, Anthropic y Mistral. El único de los grandes que si reporta sus emisiones es Meta.

Según se pueve ver en el gráfico, las emisiones varían ampliamente dependiendo de varios factores como el tamaño del modelo, la eficiencia de los datacenters y la intensidad en carbono de las redes de energía. Como referencia el entrenamiento del modelo de IA de Meta Llama 2 generó una emisión de carbono equivalente a 291 veces la que genera un viajero que va desde Lima a Miami (0.99 ton.) o 53 veces la que genera en promedio un individuo durante toda su vida (5.51 ton.).

Inferencia - Aunque las emisiones de inferencia por consulta pueden ser relativamente bajas, el impacto total puede superar al de entrenamiento cuando los modelos se consultan miles, si no millones, de veces al día. La investigación sobre las emisiones derivadas de la inferencia de modelos es aún escasa. Un estudio publicado en 2023 estimó las emisiones de diversas funciones de inferencia, identificando a la generación de imágenes como la función de mayor emisión, pudiendo llegar a ser hasta 1,000 veces mayor que la que genera la función de clasificación de un texto.

¡Gracias por llegar hasta aquí! Si te ha gustado este artículo no olvides de compartirlo.

Y si deseas profundizar sobre este tema y evaluar cómo desde Moddula podemos ayudarte, puedes hacerlo programando una sesión exploratoria en este enlace:

¡Hasta la próxima semana!

Gracias Alex, muy relevante la información sobre el impacto medioambiental, muchas veces solo miramos los avances de la IA.